Профессиональный клуб «я-ИТ-ы» – сообщество цифровых управленцев – провел онлайн-встречу на тему «Управление данными на предприятии и применение AI и ML». Эксперты обсудили инструменты эффективной работы с данными, представили кейсы, заострили внимание на проблемах управления данными как активом, дали рекомендации и поделились опытом.

Профессиональный клуб «я-ИТ-ы» – сообщество цифровых управленцев – провел онлайн-встречу на тему «Управление данными на предприятии и применение AI и ML». Эксперты обсудили инструменты эффективной работы с данными, представили кейсы, заострили внимание на проблемах управления данными как активом, дали рекомендации и поделились опытом.

Открыл мероприятие директор по организационному развитию клуба «я-ИТ-ы», директор департамента информационных технологий Tekta Group Антон Солорев. Некоммерческое сообщество цифровых управленцев, созданное более 12 лет назад, объединяет директоров по ИТ, цифровизации, цифровой трансформации и инновациям, управлению данными. Среди направлений работы клуба – повышение профессионального уровня, формирование имиджа цифрового руководителя, дружеское общение, расширение сети личных контактов.

Один из проектов, реализуемых в рамках «я-ИТ-ы», – наставничество. Его цель – способствовать ускоренному развитию нового поколения цифровых управленцев путем передачи им опыта и знаний от наставников.

В четвертый раз проводится конкурс лучших проектов «Кулибит». В этом году в соревновании приняли участие более 100 компаний. Аудит проектов, реализованных директорами по ИТ и цифровой трансформации, выполняли свыше 50 экспертов. В октябре 2024 г. состоится финал четвертого сезона.

В числе победителей конкурса «Кулибит» одного из прошлых сезонов – архитектор ИТ Олег Гришко, который на нынешней онлайн-встрече поделился опытом построения «с нуля» платформы данных в финансовой организации. Цели и задачи такой платформы могут различаться в зависимости от компании, но общей основой служат объединение данных ключевых систем на платформе, сокращение сроков подготовки аналитических отчетов, автоматизация метрик качества данных, формирование данных для продуктов и создание новых аналитических продуктов.

«В современном мире платформа данных должна строиться не столько для отчетов, сколько для аналитических продуктов или дата-продуктов, которые будут пользоваться собранными и обработанными данными», – подчеркнул эксперт. Классическими задачами для современной системы данных он назвал поддержку большого количества параллельных пользователей/отчетов (MPP-архитектура) и соответствие принятой ИТ-стратегии (Open Source решения).

Представляя архитектуру платформы данных, Олег Гришко отметил, насколько важно отделять продукты от самой платформы. Аналитические или дата-продукты не должны быть внутри платформы данных. У каждого продукта должна быть отдельная команда и инфраструктура. А платформа служит поставщиком данных для продуктов. Целями платформы данных он назвал пакетные витрины для продуктов и BI, метрики качества данных (автоматизация полного цикла контроля качества данных), а также DataScience & ML Ops как неотъемлемую часть подготовки метрик и пакетных продуктов.

Представляя архитектуру платформы данных, Олег Гришко отметил, насколько важно отделять продукты от самой платформы. Аналитические или дата-продукты не должны быть внутри платформы данных. У каждого продукта должна быть отдельная команда и инфраструктура. А платформа служит поставщиком данных для продуктов. Целями платформы данных он назвал пакетные витрины для продуктов и BI, метрики качества данных (автоматизация полного цикла контроля качества данных), а также DataScience & ML Ops как неотъемлемую часть подготовки метрик и пакетных продуктов.

Основываясь на опыте реализации проектов, эксперт дал несколько рекомендаций. В частности, обработка данных должна вестись только в пакетном режиме (обновление витрин происходит периодически). Платформа сама отгружает результаты своей работы (продуктовые online-запросы к ней запрещены). В противном случае прогнозировать SLA будет невозможно, платформа – высоконагруженный продукт. Допустимы периодические (раз-два в сутки) запросы для пакетного считывания обновлений витрин.

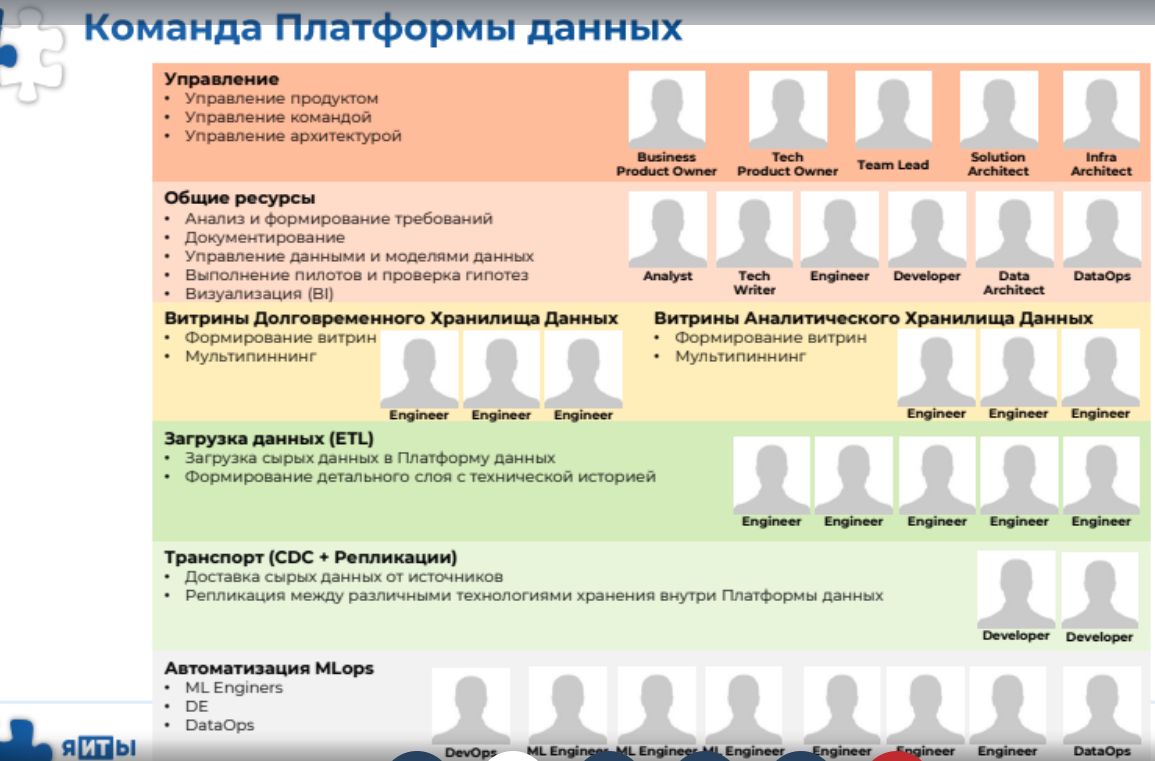

Что касается команды, то ее целями являются загрузка максимального количества источников, комфортная работа дата-сайентистов (основные внутренние пользователи), SLA по предоставлению витрин для пакетных продуктов, сквозной мультипиннинг всех данных (аналог MDM). Эти задачи можно рассматривать как KPI членов команды.

Что касается команды, то ее целями являются загрузка максимального количества источников, комфортная работа дата-сайентистов (основные внутренние пользователи), SLA по предоставлению витрин для пакетных продуктов, сквозной мультипиннинг всех данных (аналог MDM). Эти задачи можно рассматривать как KPI членов команды.

Эксперт поделился секретами построения платформы данных. Для реализации столь сложного проекта стоит заручиться поддержкой топ-менеджмента (административный ресурс точно пригодится). «Начинайте проект, только если у руководства есть в нем заинтересованность, и топ-менеджмент понимает, зачем нужна платформа», – напутствовал Олег Гришко. Не менее важно найти внутренних заказчиков (CDO, руководитель дата-сайентистов, бизнес-владельцы аналитических продуктов) и поддерживать с ними дружеские отношения. Это выручит в случаях смены приоритетов, изменения сроков, ресурсов и подобных ситуациях.

Еще один секрет – включить платформу данных в P&L аналитических продуктов, которые пользуются данными и являются высокодоходными («иначе вы станете исключительно “расходным продуктом” и развития не будет»).

Точкой отсчета служит загрузка ключевого источника – core-системы. На старте рекомендуется подобрать самую сложную, в ней будет основной объем данных, и она обеспечит наибольшую ценность. На начальном этапе не стоит гнаться за количеством источников. Эксперт не рекомендует использовать подход DataVault (причины – отсутствие гибкости и усложнение с течением времени). Еще один совет – не строить единую центральную модель данных. Для «золотого» слоя нужно использовать модели источников (элемент подхода DataMesh).

Самым опытным инженерам данных рекомендуется поручать мультипиннинг и витрины (как наиболее сложную и высоконагруженную часть). К слову, подбирать участников команды лучше всего исходя из их ценностей и жизненных ориентиров («они должны совпадать с вашими, быть зрелыми и едиными»). Не стоит выбирать, принимая во внимание только хард-скилы и «красивое» резюме.

Ключевая роль отводится техническому владельцу платформы данных (он должен быть ярким лидером, обладать большим опытом реализации сложных ИТ-проектов). Также важно заранее планировать закупки оборудования.

Данные как ценный актив требуют управления и ресурсов. Эксперт по работе с данными Виталий Сазонов посвятил свое выступление вопросам организационной структуры управления данными. В частности, он представил рамочную структуру функций управления данными, проанализировал преимущества и недостатки ряда управленческих оргструктур. Например, среди плюсов децентрализованной операционной модели, которая подходит для небольших организаций, – ее структура, четкие требования к данным внутри домена, простое внедрение, а среди минусов – неформальный характер, множество участников при принятии решений, трудности с определением владельцев данных.

Данные как ценный актив требуют управления и ресурсов. Эксперт по работе с данными Виталий Сазонов посвятил свое выступление вопросам организационной структуры управления данными. В частности, он представил рамочную структуру функций управления данными, проанализировал преимущества и недостатки ряда управленческих оргструктур. Например, среди плюсов децентрализованной операционной модели, которая подходит для небольших организаций, – ее структура, четкие требования к данным внутри домена, простое внедрение, а среди минусов – неформальный характер, множество участников при принятии решений, трудности с определением владельцев данных.

В сетевой операционной модели, похожей на предыдущую, появляется функциональность ответственных за данные (офис или отдельное лицо).

В сетевой операционной модели, похожей на предыдущую, появляется функциональность ответственных за данные (офис или отдельное лицо).

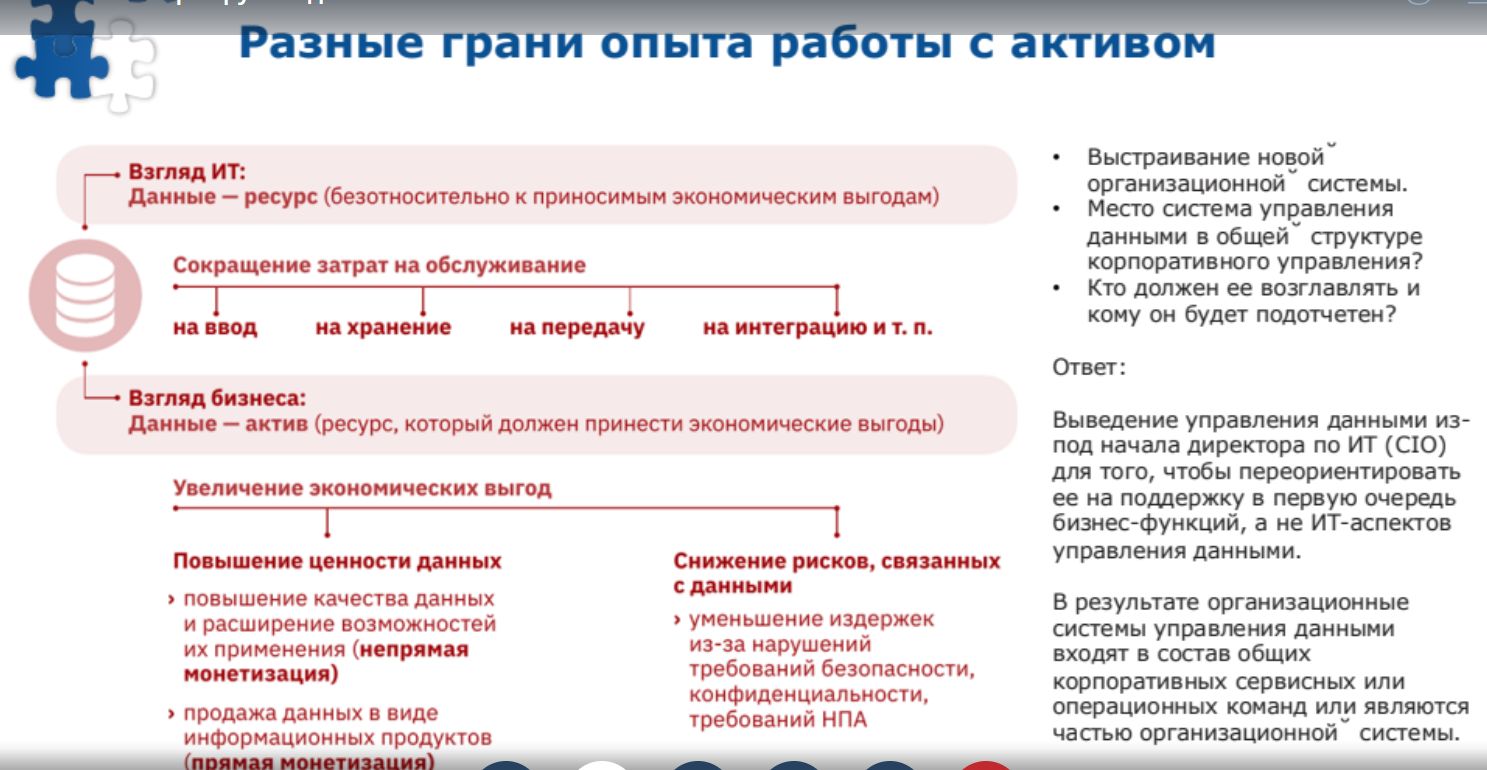

Специфика централизованной операционной модели в том, что все основные функции аккумулирует в себе дата-офис, который помогает бизнес-направлениям выполнять работу с данными по единым правилам. Модель не лишена недостатков, поскольку рискует стать «узким горлышком» при решении тех или иных задач. Взгляды ИТ и бизнеса на данные различаются. Для одних это ресурс, который надо оптимизировать, понять, как им управлять, для других – актив, с помощью которого можно зарабатывать. На зарубежных ресурсах эту функцию стараются выводить в специальное подразделение, облегчая тем самым жизнь CIO. Причем CDO «перетягивает» на себя все направления работы с данными, за исключением технологических (в этой части ему помогает ИТ-директор).

Специфика централизованной операционной модели в том, что все основные функции аккумулирует в себе дата-офис, который помогает бизнес-направлениям выполнять работу с данными по единым правилам. Модель не лишена недостатков, поскольку рискует стать «узким горлышком» при решении тех или иных задач. Взгляды ИТ и бизнеса на данные различаются. Для одних это ресурс, который надо оптимизировать, понять, как им управлять, для других – актив, с помощью которого можно зарабатывать. На зарубежных ресурсах эту функцию стараются выводить в специальное подразделение, облегчая тем самым жизнь CIO. Причем CDO «перетягивает» на себя все направления работы с данными, за исключением технологических (в этой части ему помогает ИТ-директор).

Гибридная операционная модель интегрирует опыт предыдущих моделей. При этом выделяется центр компетенций управления данными, который помогает в реализации бизнес-функций. Офис управления данными сосредоточен на регулировании политики, но не на технической экспертизе. В рамках гибридной модели выстраивается более сложная иерархия принятия решений в случае глобальных изменений.

Гибридная операционная модель интегрирует опыт предыдущих моделей. При этом выделяется центр компетенций управления данными, который помогает в реализации бизнес-функций. Офис управления данными сосредоточен на регулировании политики, но не на технической экспертизе. В рамках гибридной модели выстраивается более сложная иерархия принятия решений в случае глобальных изменений.

Классной схемой эксперт назвал федеративную операционную модель, которая требует высокого уровня готовности к взаимодействию и доверия. Однако для нее характерно негативное влияние на скорость принятия решений и общие корпоративные цели при кросс-функциональных проектах, так что приходится балансировать между потребностями отдельных направлений.

Эволюционная цепочка операционных моделей выглядит так: децентрализованная, сетевая, централизованная, гибридная, федеративная. Эксперт дал рекомендации, как выбирать оптимальную операционную модель. Отправной точкой служит оценка текущего состояния, учитываются такие параметры, как сложность и зрелость организации, предметной области, масштабируемость, поддержка руководством. Один из советов – использовать пилотные проекты, поэтапное, итерационное, каскадное или волновое внедрение. Фокусироваться следует на наиболее значимых данных. Нереалистично пытаться объять необъятное в надежде выработать универсальный и всех устраивающий̆ подход.

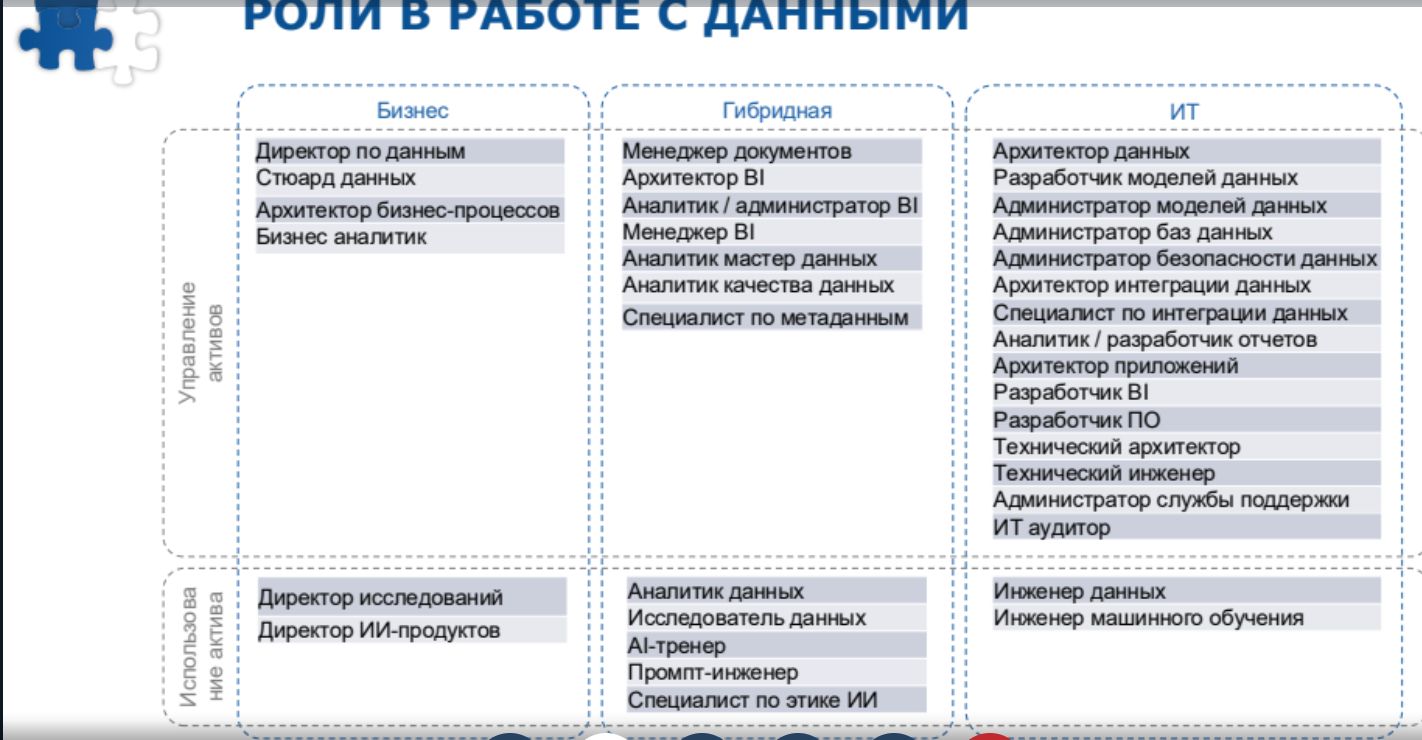

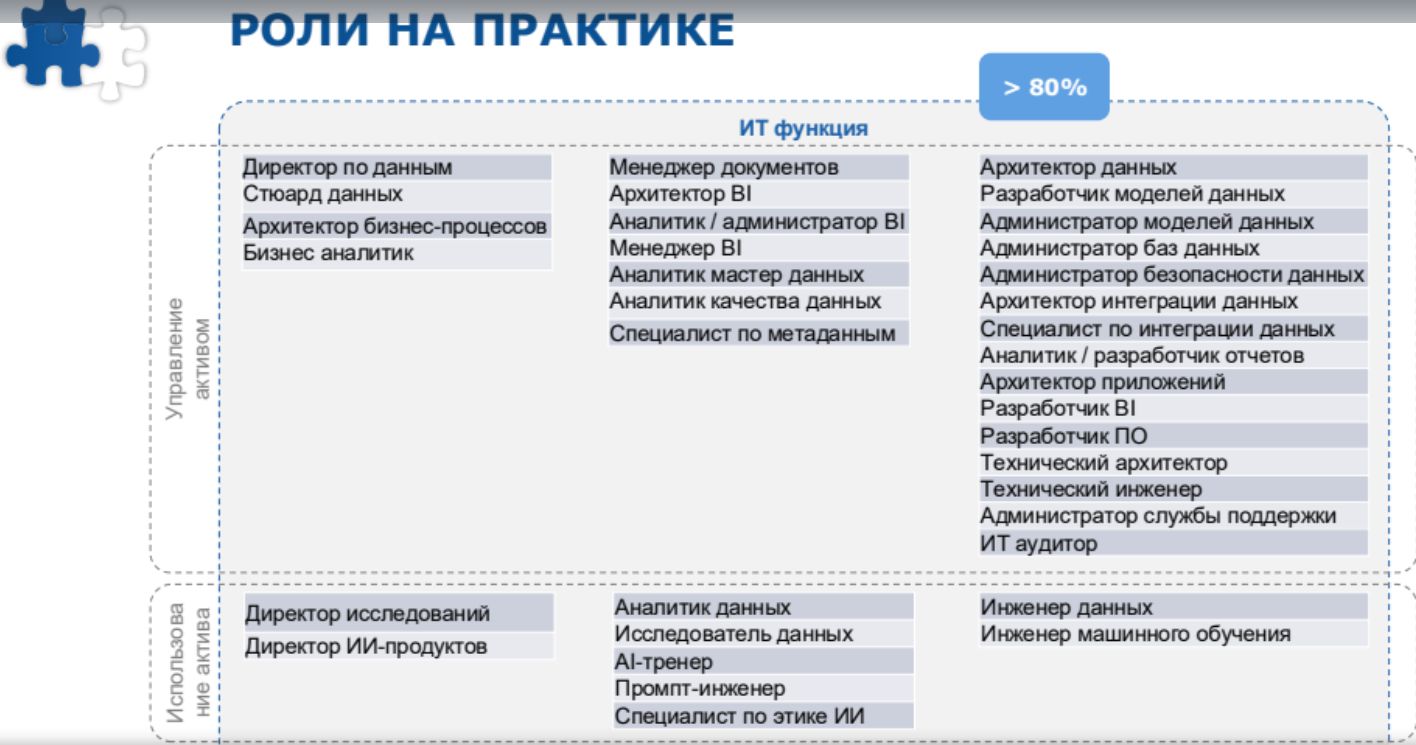

Представляют интерес роли, которые активно используются в процессе работы с данными. По мере развития этой сферы появилось более 30 наименований ролей (не позиций!), утверждает эксперт. Частично они трансформировались из ИТ, но появились и принципиально новые. Их можно группировать на бизнесовые, айтишные и гибридные (подходят и для бизнес-, и для ИТ-сферы). По поводу гибридных ролей договариваются на уровне организации, особенно в случаях, когда некоторые из них требуют сложных технологических знаний. Такие роли, как правило, передают в ИТ.

Представляют интерес роли, которые активно используются в процессе работы с данными. По мере развития этой сферы появилось более 30 наименований ролей (не позиций!), утверждает эксперт. Частично они трансформировались из ИТ, но появились и принципиально новые. Их можно группировать на бизнесовые, айтишные и гибридные (подходят и для бизнес-, и для ИТ-сферы). По поводу гибридных ролей договариваются на уровне организации, особенно в случаях, когда некоторые из них требуют сложных технологических знаний. Такие роли, как правило, передают в ИТ.

В выступлениях отмечалось, что руководителям по работе с данными зачастую поручают выполнение многих других функций, например, проведение исследований, создание продуктов на основе ИИ. Как показывает опыт, это порочная практика: CDO расфокусирует внимание, отдает предпочтение то исследованиям, то применению данных. В результате неизбежно возникают трудности с организацией собственно управления данными. Для получения максимального эффекта от использования данных упомянутые функции лучше все-таки разделять.

В выступлениях отмечалось, что руководителям по работе с данными зачастую поручают выполнение многих других функций, например, проведение исследований, создание продуктов на основе ИИ. Как показывает опыт, это порочная практика: CDO расфокусирует внимание, отдает предпочтение то исследованиям, то применению данных. В результате неизбежно возникают трудности с организацией собственно управления данными. Для получения максимального эффекта от использования данных упомянутые функции лучше все-таки разделять.

В заключение остается отметить интеллектуально насыщенную программу онлайн-встречи и высокий уровень экспертизы.

В заключение остается отметить интеллектуально насыщенную программу онлайн-встречи и высокий уровень экспертизы.